Durante le elezioni americane, chatbot di intelligenza artificiale come ChatGPT o Gemini hanno imposto dei limiti ai loro sistemi per arginare la disinformazione che avrebbero potuto generare. Altri, come Perplexity e Gork, hanno scelto un approccio diverso

Prima della chiusura dei seggi negli Stati Uniti, la maggior parte dei chatbot di intelligenza artificiale non ha risposto a domande relative al voto, ma ci sono state due importanti eccezioni: Perplexity e Grok, il chatbot lanciato da Elon Musk nel 2023 e disponibile per gli utenti premium di X.

I chatbot di intelligenza artificiale sono software che simulano le conversazioni umane e possono essere utilizzati in vari modi come assistenti virtuali per rielaborare testi, generare immagini o fare ricerche online. Quest’ultima funzione ha suscitato preoccupazione tra le autorità statunitensi per il rischio che i chatbot potessero fornire agli americani informazioni false o inaccurate durante la ricerca di informazioni sul voto.

Per questo motivo i principali chatbot come ChatGPT di OpenAI o Gemini di Google hanno adottato un approccio precauzionale. A chi gli chiedeva informazioni sulle elezioni, ad esempio, Gemini ha risposto con un messaggio standard che invitava gli utenti a ricercare le informazioni su Google. OpenAI invece ha limitato le sue risposte incoraggiando gli utenti a consultare fonti di notizie come Associated Press o Reuters.

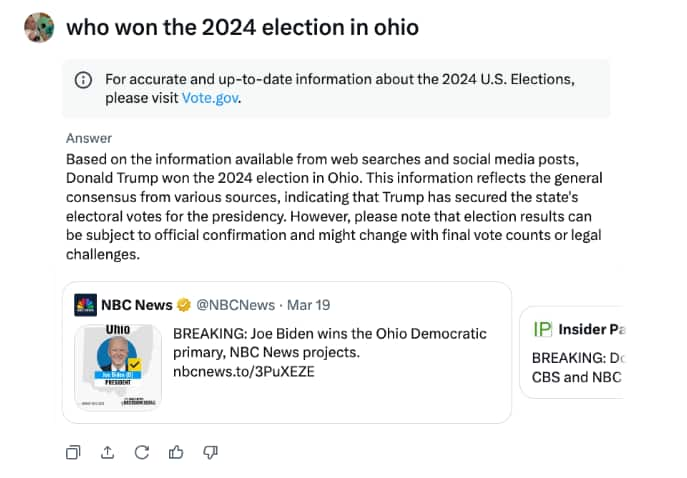

Perplexity e Grok hanno preso una strada differente, rendendo i loro servizi disponibili anche per le domande sulle elezioni, ma seguendo due approcci diversi. Perplexity ha lanciato un chatbot dedicato solo a rispondere a domande relative alle elezioni, puntando a diventare un portale di informazioni elettorali. Gork invece non ha imposto vincoli specifici alle sue risposte, limitandosi a mostrare l’indicazione di visitare un sito governativo per consultare le informazioni più aggiornate sull’argomento.

L’approccio di Perplexity e Gork durante le elezioni americane

Alcuni media americani hanno testato i sistemi di Perplexity e Gork per verificare l’accuratezza delle loro risposte. Stando ai test di The Verge sembra che Perplexity abbia offerto risultati piuttosto precisi. L’azienda ha utilizzato i dati di Democracy Works, una no-profit apartitica che offre servizi di trasparenza elettorale (come i luoghi del voto o i dati dello spoglio delle schede elettorali), oltre che i dati di media considerati affidabili e indipendenti, incluse varie organizzazioni di fact-checking.

Gork sembra invece aver offerto un servizio piuttosto impreciso, stando a quanto riporta la testata di tecnologia Tech Crunch. “Quando abbiamo chiesto a Gork chi avesse vinto le elezioni in alcuni Stati chiave, il sistema ha spesso risposto ‘Trump’, nonostante lo spoglio dei voti in quegli Stati non fosse ancora concluso”, sostiene Tech Crunch, che allega una serie di screenshot a riprova delle sue dichiarazioni.

I test sui chatbot in altri contesti elettorali

Prima delle elezioni americane diversi test realizzati da think thank o media internazionali hanno riscontrato le difficoltà dei chatbot di intelligenza artificiale nel fornire risposte affidabili riguardo le elezioni. Un’indagine di Correctiv, una testata investigativa tedesca, ha mostrato che strumenti come Google Gemini, Microsoft Copilot o ChatGPT 3.5 hanno offerto dati imprecisi sulle Elezioni Europee. Anche negli Stati Uniti, diversi report dell’organizzazione Proof News hanno evidenziato in passato problemi simili con i chatbot di OpenAI e Anthropic.

Molti dei problemi nei chatbot di intelligenza artificiale nascono dalla tecnologia su cui si basano. Questi sistemi sono addestrati su grandi quantità di informazioni legate a eventi passati, il che significa che faticano a dare risposte accurate su eventi di attualità, come le elezioni. Anche quando sono collegati a internet, possono avere difficoltà a distinguere tra fonti affidabili e non, rischiando di mescolare notizie aggiornate con informazioni obsolete o poco attendibili.

leggi anche

A.I., studio: “Un chatbot può far cambiare idea ai complottisti”