da Hardware Upgrade :

Si chiama Artificial Intelligence Unit, in breve AIU, il chip specializzato per la gestione dei calcoli legati all’intelligenza artificiale messo a punto dall’IBM Research AI Hardware Center. Secondo IBM, “stiamo esaurendo la potenza di calcolo” perch, a fronte di una crescita esponenziale dei modelli di intelligenza artificiale, l’hardware necessario ad addestrarli ed eseguirli non progredito con altrettanta rapidit.

Ed qui che la AIU entra in gioco. Le tradizionali CPU, pensate per essere flessibili e in grado di far girare software “general purpose”, ossia senza un fine preciso, sono inadeguate a gestire l’enorme mole di operazioni parallele che i modelli di deep learning richiedono. “Un’auto con motore a benzina potrebbe funzionare con il diesel, ma se l’obiettivo massimizzare la velocit e l’efficienza, necessario il carburante giusto. Lo stesso principio si applica all’IA”.

Eseguire modelli di deep learning su CPU e GPU, per IBM, non la soluzione migliore. “Abbiamo trascorso gli ultimi 5 anni a capire come progettare un chip su misura per le statistiche dell’IA moderna”, un percorso che ha portato IBM a identificare due strade da seguire.

La prima quella di puntare su una minore precisione di calcolo. A differenza delle CPU, i chip di IA non devono essere ultra-precisi perch “non calcoliamo le traiettorie per far atterrare un veicolo spaziale sulla Luna o stimiamo il numero di peli su un gatto. Facciamo previsioni e prediamo decisioni che non richiedono una simile precisione”.

Si pu quindi passare da un’aritmetica in virgola mobile a 32 bit a formati che contengono un quarto delle informazioni. In questo modo si riduce drasticamente la quantit di calcoli necessari per addestrare ed eseguire un modello di intelligenza artificiale, senza sacrificare la precisione. Parallelamente, puntare su formati pi snelli consente di ridurre la quantit di dati che necessario spostare “da e verso la memoria”.

“La nostra AIU usa una gamma di formati di bit pi piccoli, comprese rappresentazioni in virgola mobile e interi, per rendere l’esecuzione di un modello di intelligenza artificiale molto meno dispendiosa in termini di memoria. Sfruttiamo le principali scoperte IBM degli ultimi cinque anni per trovare il miglior compromesso tra velocit e precisione”.

La seconda soluzione quella di creare un chip esplicitamente per l’IA, predisposto per semplificare i flussi di lavoro. “Poich la maggior parte dei calcoli di intelligenza artificiale coinvolge la moltiplicazione di matrici e vettori, la nostra architettura presenta un layout pi semplice rispetto a una CPU generica. IBM AIU stata inoltre progettata per inviare i dati direttamente da un motore di calcolo all’altro, creando enormi risparmi energetici”.

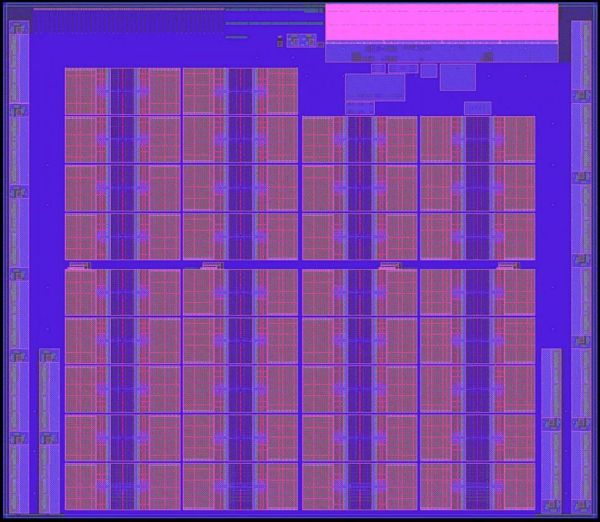

Insomma, IBM AIU non altro che un ASIC (application-specific integrated circuit) progettato per il deep learning e programmabile per gestire diversi tipi di operazioni, che si tratti di elaborare la lingua parlata, parole o immagini su uno schermo. Nel chip ci sono 32 core e un totale di 23 miliardi di transistor, inoltre collegabile facilmente a un computer o un server tramite slot PCI Express.

IBM AIU non altro che la versione “in grande” dell’acceleratore di IA integrato in Telum, altra soluzione della societ statunitense. Il nuovo chip, a differenza di Telum (7 nm), prodotto con processo a 5 nanometri.