da Hardware Upgrade :

NVIDIA GeForce RTX 4090 finalmente tra noi dopo tanti mesi di indiscrezioni pi o meno veritiere. La scheda, che nell’immaginario collettivo va a prendere il posto della GeForce RTX 3090 e della 3090 Ti, si presenta con tante novit legate alla nuova architettura Ada Lovelace di NVIDIA.

Abbiamo dedicato un apposito articolo alle novit dell’architettura, a cui vi rimandiamo se desiderate approfondire le novit tecniche dietro alle nuove GPU. Qui, invece, ci concentriamo sul prodotto e le prestazioni della nuova generazione di NVIDIA analizzando la GeForce RTX 4090 Founders Edition (FE).

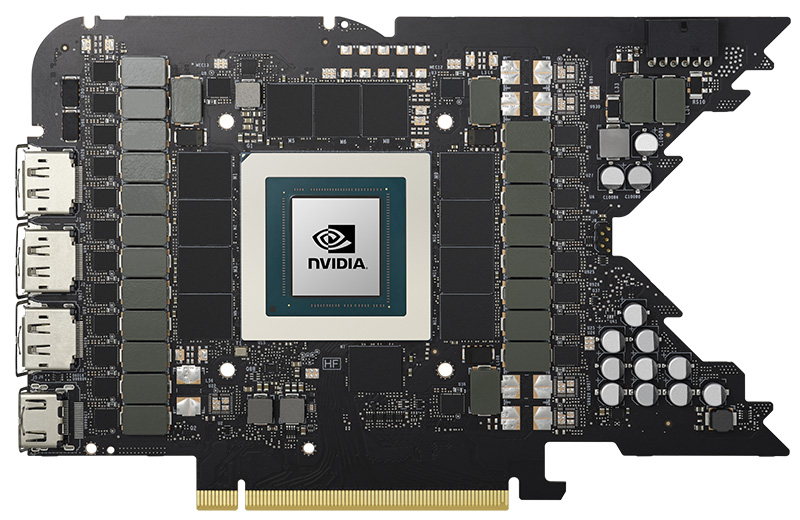

Partiamo dalle specifiche tecniche. GeForce RTX 4090 basata su una GPU AD102 con 16384 CUDA core attivi, 128 RT core di terza generazione e 512 Tensor core di quarta generazione. Il chip grafico, secondo le specifiche NVIDIA, si presenta con un base clock di 2,23 GHz e un boost clock di 2,52 GHz. La GPU, cos come le altre in arrivo sui modelli RTX 4080, realizzata da TSMC con processo 4N, un N5 ottimizzato per le necessit di NVIDIA: si tratta di un passo avanti rispetto all’8N di Samsung usato per le RTX 3000.

Accanto alla GPU troviamo 24 GB di memoria GDDR6X a 21 Gbps per una bandwidth pari a circa 1 TB/s (1008 GB/s per l’esattezza) per mezzo del bus a 384 bit. La VRAM fornita da Micron tramite chip da 16 gigabit ed posizionata su un’unica faccia del PCB; inoltre, prodotta con un processo produttivo pi avanzato rispetto al passato che consente di avere temperature inferiori di 10 C (secondo NVIDIA).

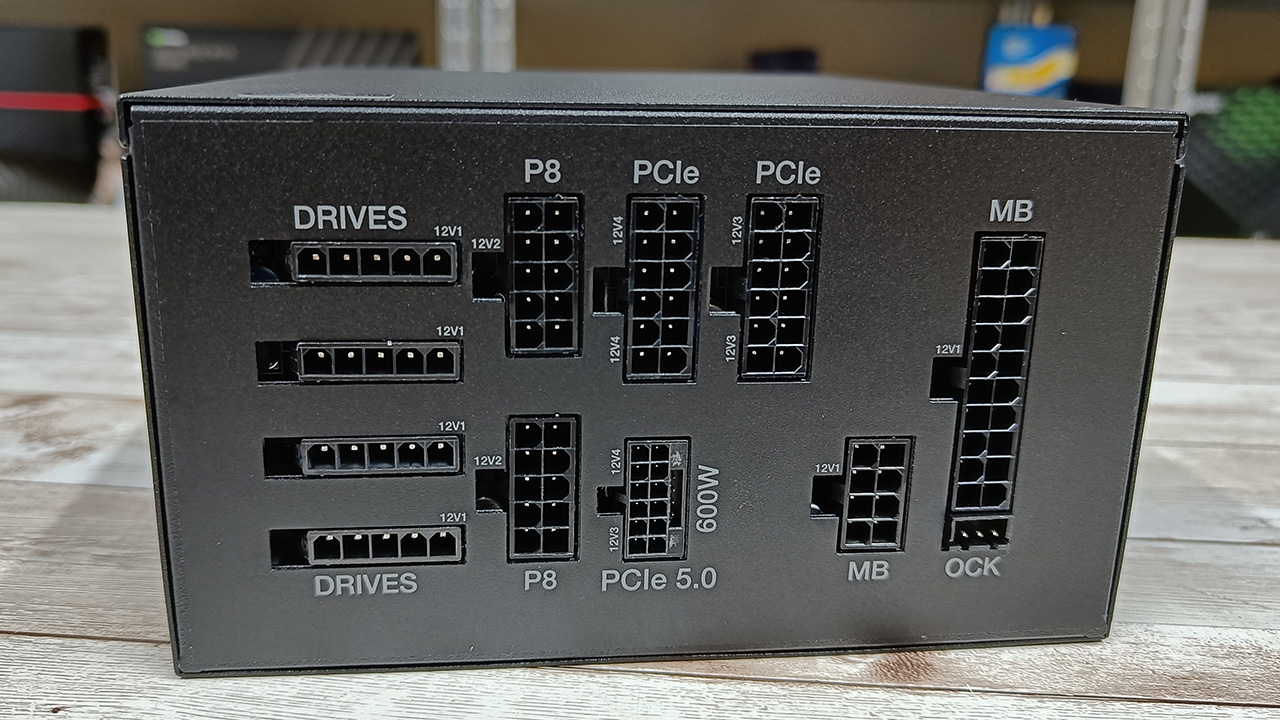

Per quanto riguarda la richiesta energetica, la scheda ha un TGP di 450W, che lo stesso della GeForce RTX 3090 Ti. Non cambia nemmeno l’alimentatore consigliato da NVIDIA, un modello da 850W (chiaramente con un’alta efficienza). Va sottolineato che la Founders Edition si presenta con un singolo connettore di alimentazione ausiliaria, il cosiddetto connettore PCIe Gen 5 o 12VHPWR, dotato di 12+4 pin e tecnicamente capace con l’apposito cavo di sostenere 600W.

In realt, insieme alla scheda di NVIDIA c’ un adattatore per collegarla agli alimentatori tradizionali con ben 4 connettori a 8 pin: necessario usarne tre (come per la 3090 Ti) per assicurarne il funzionamento, mentre il quarto necessario collegarlo in caso di overclock spinto.

Quanto al prezzo, per questa soluzione NVIDIA richiede 1979 euro IVA inclusa, listino che da considerarsi “di partenza” e che sar sfondato dalle soluzioni custom dei partner, che si piazzeranno in una fascia tra 2000 e 2500 euro a seconda del progetto.

La GeForce RTX 4090 FE equipaggiata con un enorme dissipatore di raffreddamento, completamente metallico. Un’enorme struttura dissipante, che riprende quanto fatto da NVIDIA per le Founders Edition di precedente generazione. Allo stesso modo, l’azienda ha deciso di affidarsi a un PCB con un finale a V utile per incastonare le due ventole. Ventole che, peraltro, sono pi grandi (11,5 cm di diametro contro 11 cm della 3090/Ti) e aumentano il flusso d’aria del 20%.

Dalla scorsa generazione di Founders Edition, NVIDIA ha deciso di adottare un progetto diverso per il sistema di raffreddamento delle sue proposte di riferimento, capace di sfruttare quella che ormai la configurazione classica dei PC desktop gaming. I case, infatti, hanno una o pi ventole frontali che immettono aria fresca all’interno.

Questa aria fresca corre proprio nella parte bassa centrale del case e pu essere intercettata dalle ventole della scheda video. La prima ventola, quella di destra incastonata nella scheda proprio grazie al finale a V del PCB, raccoglie l’aria fresca e soffia fuori l’aria calda dalla parte superiore, affinch venga a sua volta catturata da una ventola collocata nella parte posteriore del case. La ventola di sinistra invece collocata in prossimit della GPU e ha il compito di buttare fuori l’aria calda dalle feritoie posteriori. Le due ventole non sono pi su una faccia della scheda una accanto all’altra e sullo stesso asse, ma quella di destra nella parte alta e quella sinistra in quella bassa. Sono, insomma, sfalsate l’una rispetto all’altra.

un progetto che si dimostrato efficace con la scorsa generazione 3000 e che i partner hanno riproposto – vedremo se la GeForce RTX 4090, nonostante la potenza, si terr su temperature entro la soglia di guardia.

Il PCB della GeForce RTX 4090 FE, nonostante le piccole dimensioni, prevede un totale di 23 fasi di cui 20 sono dedicate alla GPU e 3 alla memoria. NVIDIA, inoltre, ha migliorato la gestione dell’alimentazione per non avere forti picchi di corrente e tensione che potrebbero mettere in crisi gli alimentatori. A tal proposito, NVIDIA ha recentemente parlato dei requisiti di alimentazione, rassicurando tutti sull’uso degli alimentatori “non ATX 3.0” e degli adattatori. Tutti i dettagli in merito potete leggerli qui.

Quanto al progetto, la scheda leggermente pi corta se raffrontata alla RTX 3090 Ti o alla RTX 3090, ma un po’ pi tozza. La GeForce RTX 4090 FE lunga 304 mm, larga 137 mm e spessa 61 mm, occupando cos tre slot sulla motherboard. Insomma, enorme, ma lo sono anche le FE precedenti.

La RTX 3090/Ti invece lunga 313 mm e larga 138 mm, mentre lo spessore pari 54 mm. Quanto alle porte posteriori, non sembra cambiare nulla con una HDMI e tre DisplayPort, ma c’ da ravvisare il passaggio da una HDMI 2.1 a una 2.1a, mentre la versione della DisplayPort rimane la 1.4a.

Frontalmente, come potete vedere nella galleria, la scheda dotata di un pannellino magnetico che, una volta rimosso, presenta fori filettati in modo che la scheda possa essere fissata a una staffa. In ultimo, bene segnalare che l’interfaccia della scheda PCI Express 4.0 x16.

Cosa cambia tra Ada Lovelace e Ampere (in sintesi)

Rimandandovi al nostro approfondimento sull’architettura Ada Lovelace, sintetizziamo in pochi punti quali sono le novit del progetto rispetto ad Ampere e alle schede di precedente generazione. La prima novit da cui non si pu prescindere il processo produttivo: NVIDIA ha cambiato partner per questa generazione passando da Samsung a TSMC. Dal processo 8N usato per le GPU Ampere si quindi passati alla tecnologia 4N delle GPU Ada Lovelace, una versione ottimizzata del processo N5 di TSMC.

| AD102 (completamente attivo) | GA102 (completamente attivo) | |

| Architettura | Ada Lovelace | Ampere |

| Processo produttivo | TSMC 4N | Samsung 8N |

| Transistor | 76,3 miliardi | 28,3 miliardi |

| Dimensione die | 608,5 mm | 628,4 mm |

| Streaming Multiprocessor | 144 | 84 |

| CUDA Core | 18432 | 10752 |

| Tensor Core | 576 | 336 |

| RT Core | 144 | 84 |

| ROPs | 192 | 112 |

| Cache L2 | 98,3 MB | 6,1 MB |

| Bus | 384 bit | 384 bit |

Un processo pi avanzato, in genere, equivale alla possibilit di alzare le frequenze operative, aumentare i transistor e di conseguenza il numero di unit di calcolo, la quantit di cache e le funzionalit di un chip. Allo stesso tempo, un processo avanzato consente anche di ridurre i consumi.

NVIDIA ha sfruttato tutto questo per proporci con Ada Lovelace un’architettura pi potente ma con consumi allineati alle top di gamma precedenti. La prima cosa che emerge guardando le specifiche tecniche a confronto il numero di transistor della GPU. Con 76,3 miliardi di transistor in un’area di 608,5 mm2, AD102 compie un netto balzo in avanti rispetto ai 28,3 miliardi di GA102, su un’area di 628,4 mm2.

In pratica, il nuovo processo produttivo ha permesso a NVIDIA di integrare 48 miliardi di transistor in pi in circa 20 mm2 in meno. Tutto questo budget di transistor per cosa stato utilizzato? Anzitutto per incrementare il numero di CUDA core, che nel caso di AD102 pari a 18432 unit, un balzo di 7680 core rispetto ai 10752 GA102. In pratica sono aumentati del 70%, anche se nel caso della GeForce RTX 4090 il numero di core si ferma a 16384 (quindi +52% rispetto alla RTX 3090 Ti e +56% sulla RTX 3090).

NVIDIA, inoltre, ha aumentato il numero di RT e Tensor core, oltre ad averli migliorati tecnicamente: si passa dagli 84 RT core e 336 Tensor core di GA102 a 144 RT core e 576 Tensor core di AD102. Anche in questo caso il balzo in avanti del 70% (e non poteva essere altrimenti visto che rimane il rapporto di 1 RT core per SM e 4 Tensor core per SM).

L’altra novit importante riguarda la cache L2, espansa in modo netto rispetto ad Ampere: AD102 presenta 98,3 MB di cache L2 nella sua forma completa, mentre in GA102 si arrivava a un massimo di 6,1 MB. I 90 MB di cache in pi sono funzionali a mantenere pi dati in prossimit delle unit di calcolo, senza dover ricorrere alla VRAM, velocizzando i processi. Per implementare pi risorse e cache L2, NVIDIA ha deciso di sacrificare l’interconnessione NVLink. Sale anche il numero delle ROPs, da 112 del GA102 a 192 su AD102.

| GeForce RTX 4090 | GeForce RTX 3090 Ti | GeForce RTX 3090 | |

| Architettura | Ada Lovelace | Ampere | Ampere |

| CUDA core | 16384 | 10752 | 10496 |

| RT core | 128 | 84 | 82 |

| Tensor core | 512 | 336 | 328 |

| ROPs | 176 | 112 | 112 |

| Boost Clock (GHz) | 2,52 | 1,56 | 1,39 |

| Base Clock (GHz) | 2,23 | 1,86 | 1,69 |

| Memoria | 24 GB GDDR6X 21 Gbps | 24 GB GDDR6X 21 Gbps | 24 GB GDDR6X 19,5 Gbps |

| Bandwidth | 1008 GB/s | 1008 GB/s | 936,2 GB/s |

| Bus | 384 bit | 384 bit | 384 bit |

| TGP | 450W | 450W | 350W |

Core, cache cosa manca? Ah, le frequenze. Se guardiamo il clock della RTX 4090 FE e lo confrontiamo con quello della RTX 3090 Ti, osserviamo un netto balzo in avanti. Il base clock sale da 1,67 GHz a 2,23 GHz (+560 MHz), mentre il boost clock da 1,86 GHz a 2,52 GHz (+660 MHz). Questa la situazione dati alla mano: sappiamo per che gli algoritmi di boost si spingono ben oltre in base al carico e alle condizioni operative. Quanto per la cache tanto per la frequenza, NVIDIA sembra aver seguito quanto fatto da AMD con RDNA 2 la scorsa generazione.

Un’altra ma importante novit il miglioramento di NVENC, l’encoder hardware dedicato presente nelle GPU NVIDIA, fondamentale per la gestione di streaming e contenuti video. Con Ada Lovelace abbiamo l’ottava generazione dell’encoder che implementa il supporto all’encoding AV1. La precedente generazione Ampere supportava la codifica AV1, ma non la decodifica.

AV1 un codec che richiede una bandwidth del 50% e permette la riproduzione di video fino all’8K HDR senza un grande impatto prestazionale sulla CPU. L’encoder di Ada Lovelace il 40% pi efficiente di quello H.264 della scorsa generazione, ma non solo: per migliorare le prestazioni di codifica, la GPU AD102 offre un doppio encoder NVENC per permettere la codifica a 8K/60 oppure la gestione di quattro flussi 4K/60. Per quanto riguarda invece NVDEC, il decoder hardware, lo stesso della generazione Ampere.

Configurazione di prova

Abbiamo svolto i test su una nuova piattaforma basata sulla motherboard ASUS ROG Crosshair X670E Hero, 32 GB dimemoriaG.Skill Trident Z5 DDR5-6000 (30-38-38-38-96) e un processore AMD Ryzen 9 7950X con 16 core e 32 thread. Per la prova abbiamo usato anche un alimentatore da 1200W di Corsair, che ci ha fornito anche un cavo adeguato al collegamento della GeForce RTX 4090. Potete vederne alcune foto di seguito:

In redazione ci anche arrivato un PSU firmato Be Quiet, un Dark Power 13 da 1000W, gi dotato di connettore 12VHPWR a bordo.

Tutte le schede che vedrete nei grafici sono state provate con Resizable BAR attivo. Per le GPU NVIDIA di precedente generazione abbiamo usato i driver516.94, per la RTX 4090 i driver forniti da NVIDIA alla stampa numerati come521.90. Per quanto riguarda le GPU AMD Radeon, abbiamo usato i driver Radeon Software Adrenalin Edition 22.9.2.

Tutte le GPU NVIDIA sono modelli Founders Edition; nel caso di AMD, la scheda Radeon RX 6950 XT una GAMING OC di Gigabyte mentre gli altri modelli invece sono schede di riferimento.

Prestazioni GeForce RTX 4090 Founders Edition

RTX 4090 nei giochi senza ray tracing

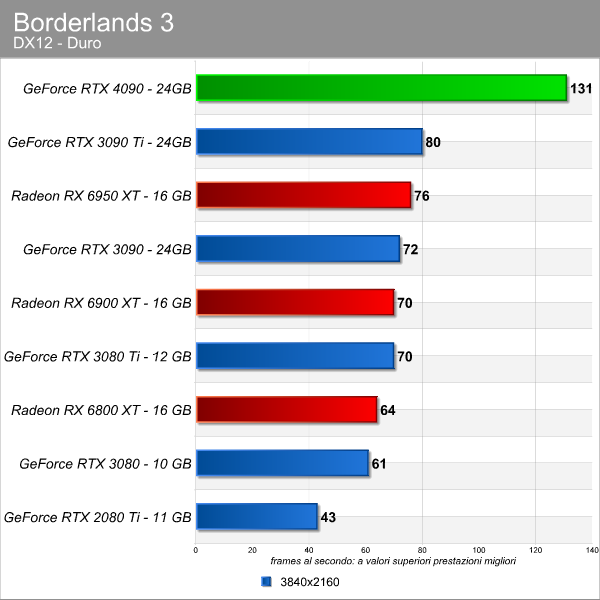

Abbiamo testato la nuova top di gamma NVIDIA anzitutto con i giochi basati sulla rasterizzazione: in futuro sempre meno titoli saranno privi di ray tracing e tecnologie di upscaling, ma per ora ancora interessante vedere come si comporta la scheda in tale frangente, che per decenni stato il terreno di sfida tra le GPU e motivo di discussione per gli appassionati. Partiamo da Borderlands 3.

Il primo impatto incredibile. Dagli 80 fps circa della GeForce RTX 3090 Ti saliamo ai circa 130 fps della GeForce RTX 4090, un passo avanti di 50 fps che messo in percentuale vuol dire un +64% circa.

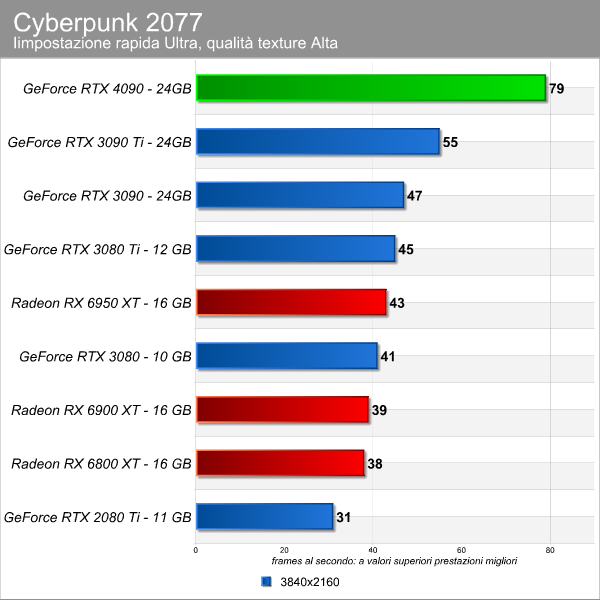

Passando a Cyberpunk 2077 osserviamo un salto da 55 a 79 fps, un incremento del 44% per la GeForce RTX 4090che, seppur sotto l’incremento ravvisato in Borderlands 3, rappresenta un grande miglioramento.

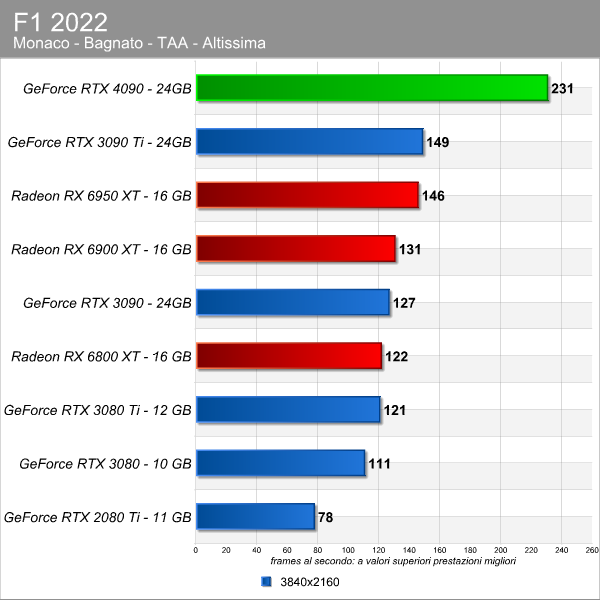

In F1 2022, la GeForce RTX 4090 vola come Verstappen nell’ultimo mondiale di Formula 1 e stacca la Ferrari della scorsa generazione, la RTX 3090 Ti, di ben il 55%.

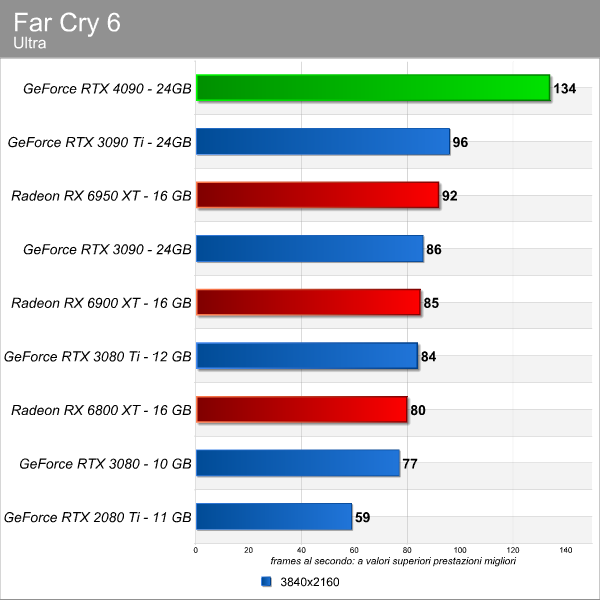

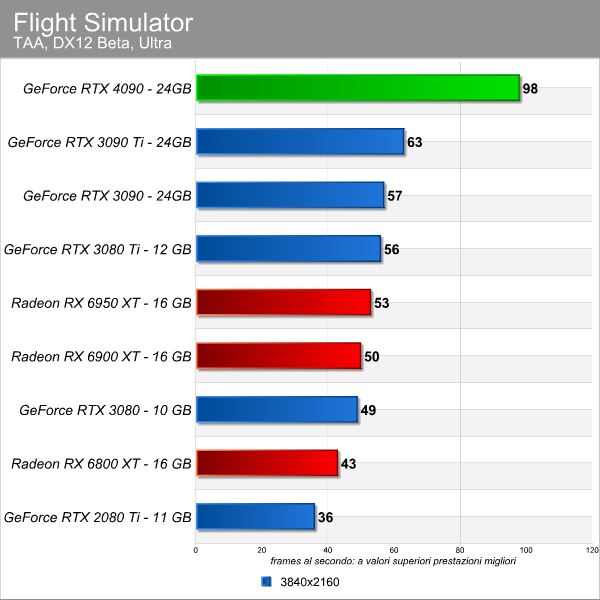

Pi vicino al risultato di Cyberpunk 2077 il +40% fatto segnare dalla RTX 4090 sulla RTX 3090 Ti in Far Cry 6, mentre in Flight Simulator la nuova arrivata fa segnare un frame rate vicino ai 100 fps nel nostro scenario di prova sopravanzando la RTX 3090 Ti del 56%.

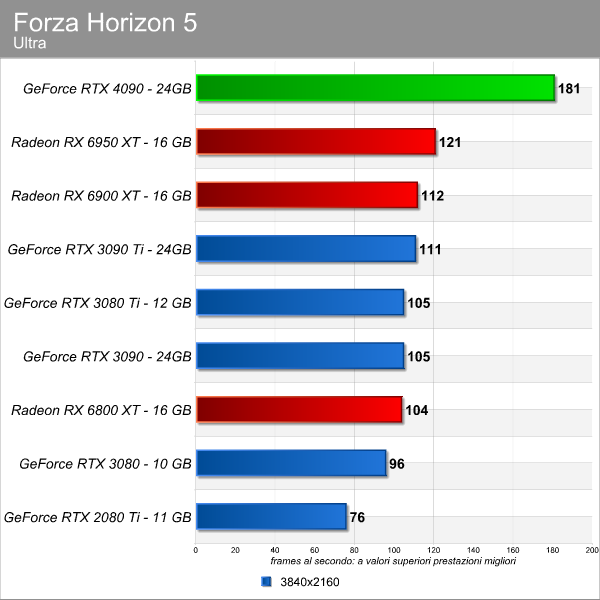

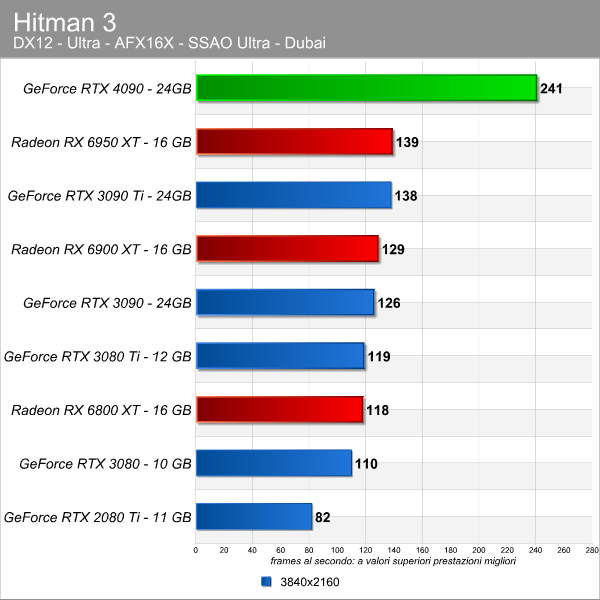

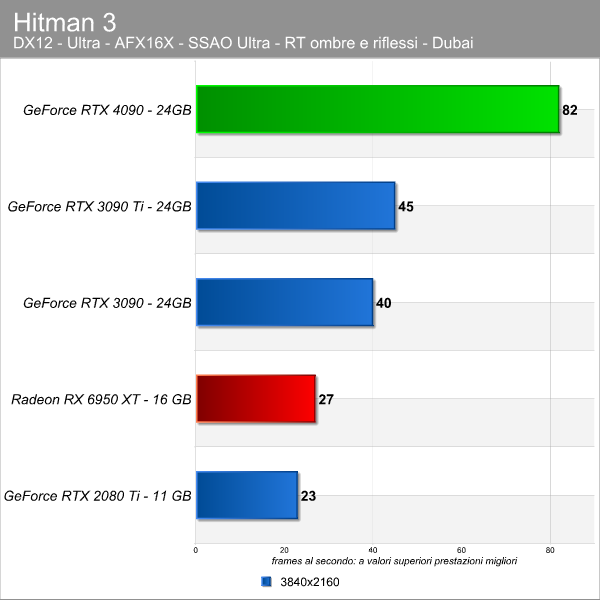

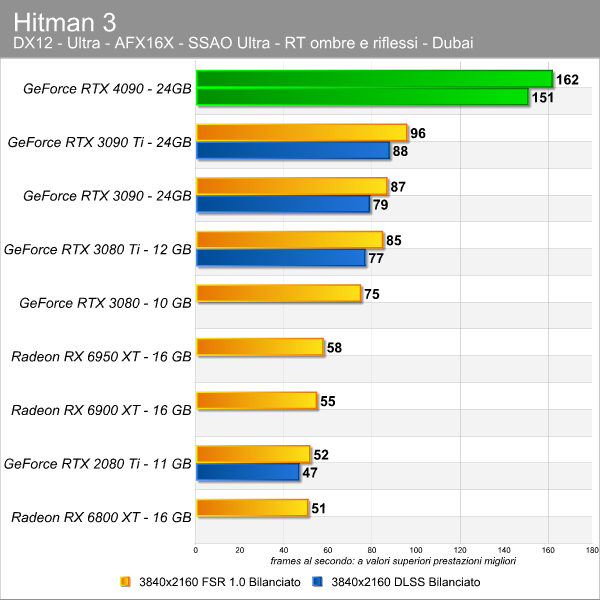

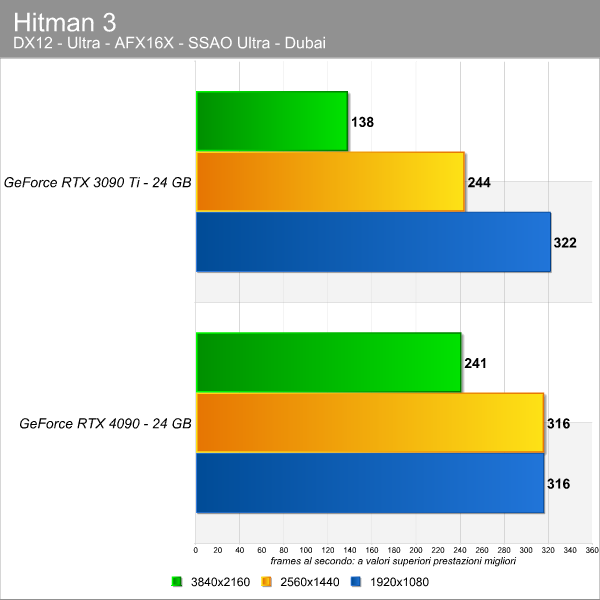

Nel test di Forza Horizon 5 c’ un gap tra la top di gamma della scorsa generazione e la nuova RTX 4090 di 70 fps, il che significa un +63%. Ancora meglio va in Hitman 3, dove la RTX 4090 fa letteralmente mangiare la polvere alla RTX 3090 con un +75%.

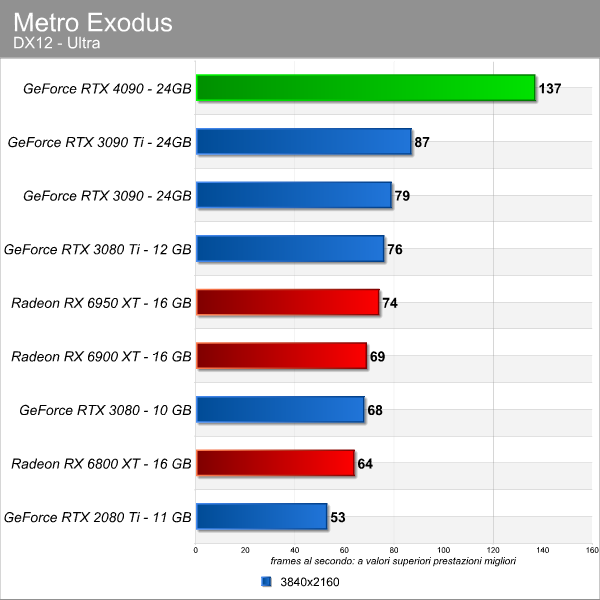

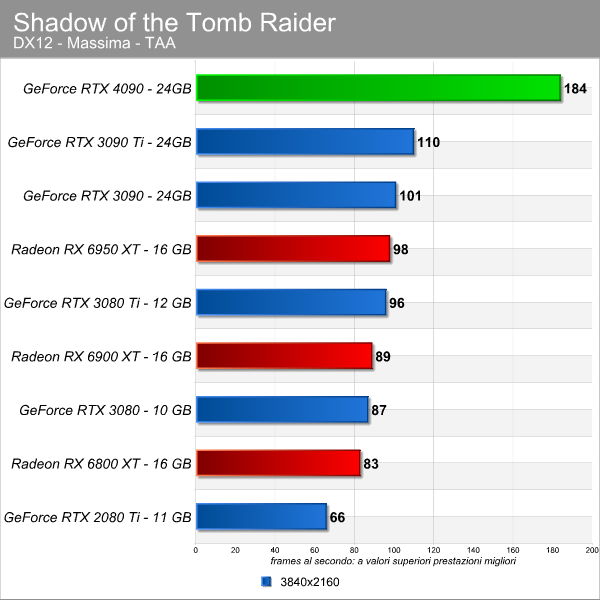

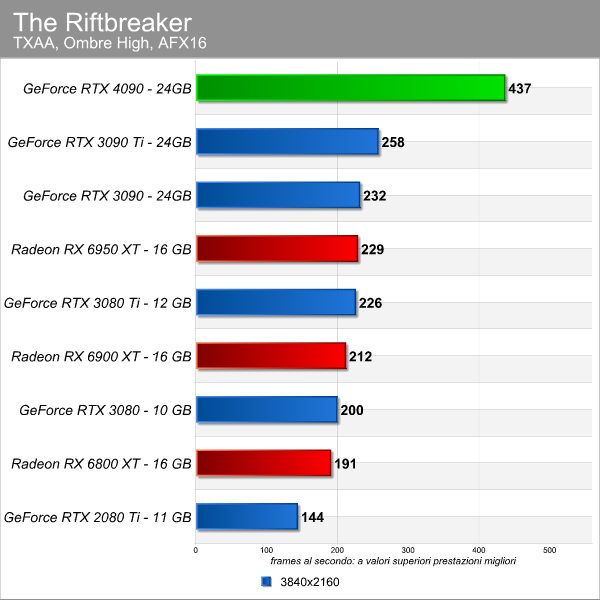

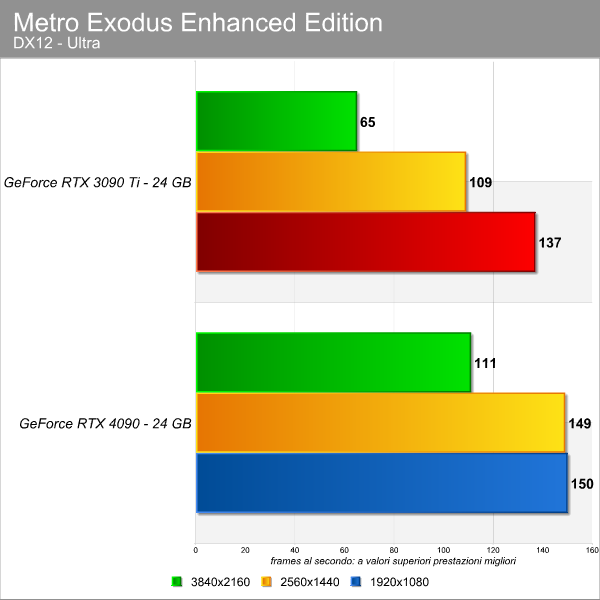

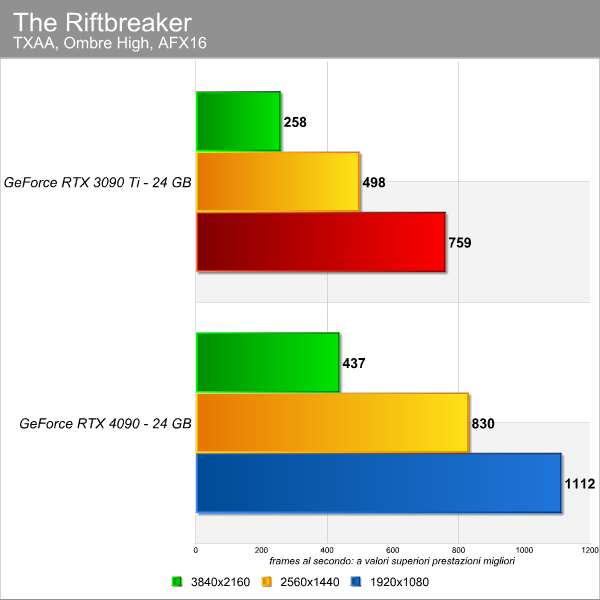

Incremento prestazionale di 50 fps nel caso di Metro Exodus, con la RTX 4090 che davanti del 57% alla RTX 3090 Ti. Anche in The Riftbreaker la nuova GPU vola, con un +69% in termini di frame rate medio sulla top di gamma precedente. Gap simile, infine, in Shadow of the Tomb Raider.

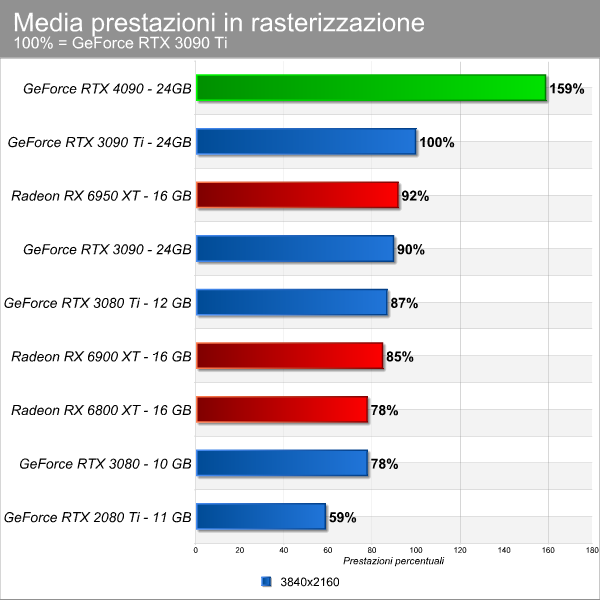

Tirata una riga, la RTX 4090 si dimostra capace di prestazioni in rasterizzazione decisamente superiori alla RTX 3090 Ti: nella nostra lineup di test la scheda fa segnare una media del 59% superiore alla RTX 3090 Ti.

Rispetto alla RTX 3090 “non Ti”, il balzo impressionante: +77%, mentre se andiamo a prendere come riferimento la RTX 2080 Ti, la top di gamma della serie 2000, abbiamo un balzo prestazionale del 172%, quasi due volte di pi. Se invece rapportiamo la RTX 4090 con la RX 6950 XT, la nuova GPU di NVIDIA il 73% pi veloce.

RTX 4090 nei giochi con ray tracing (ma senza upscaling)

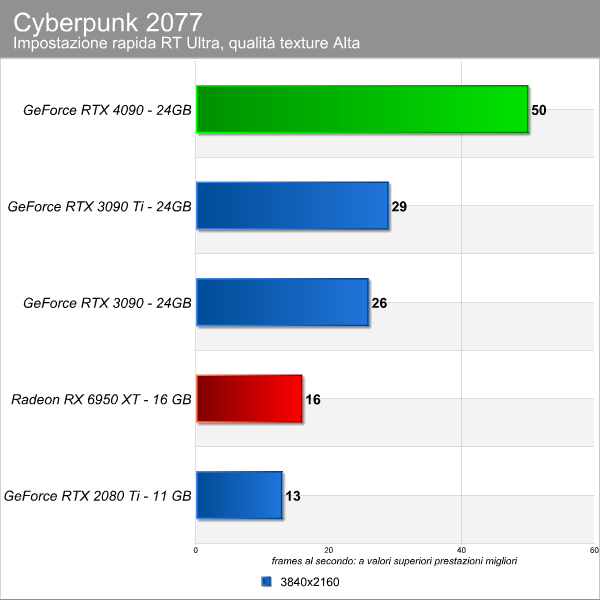

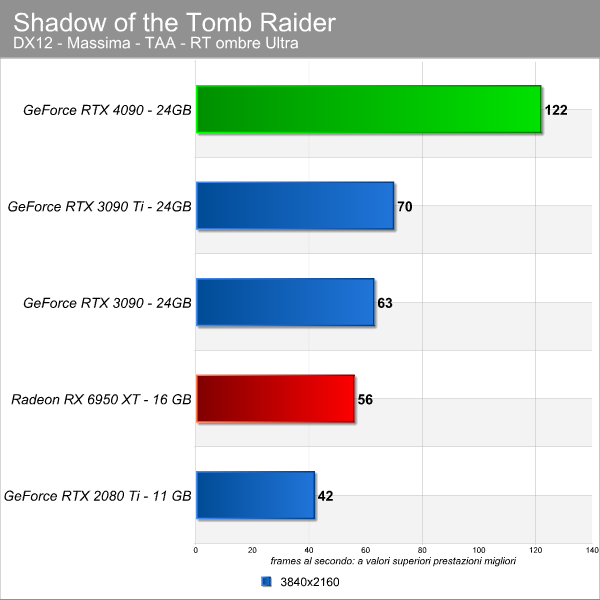

Premesso che giocare con il ray tracing senza tecnologie di upscaling ad alta risoluzione non consigliabile, nemmeno con delle GPU di fascia alta, eravamo curiosi di vedere il comportamento della nuova scheda video e in particolare delle unit RT core di 3a generazione.

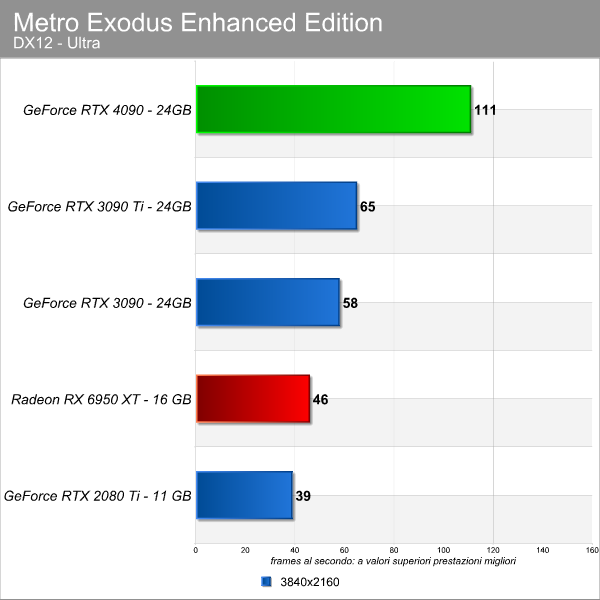

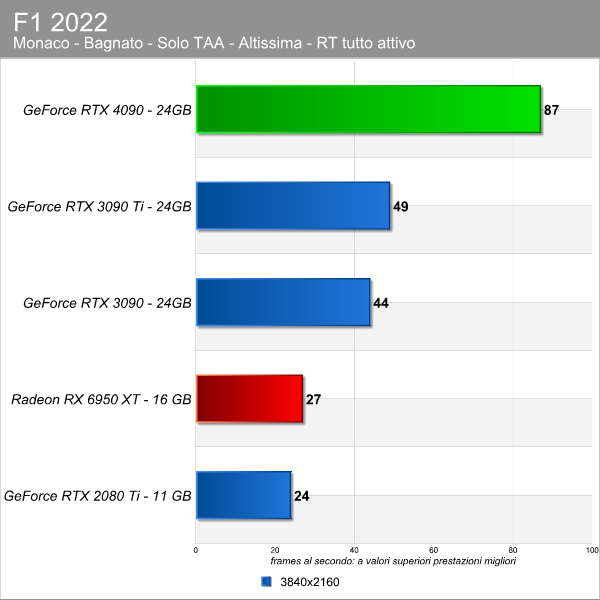

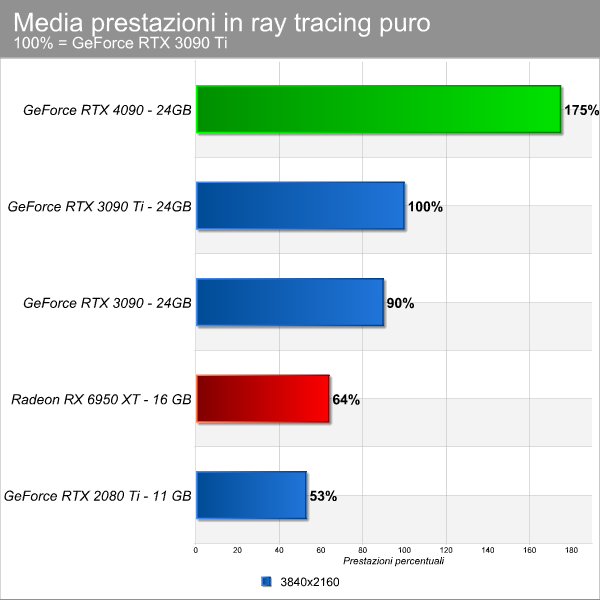

Abbiamo svolto alcuni benchmark per capire come rispondono le diverse top di gamma attivando il ray tracing, ma nessuna tecnologia di upscaling. Metro Exodus Enhanced Edition, Shadow of the Tomb Raider e Cyberpunk 2077 ci mostrano un balzo avanti notevole dalla RTX 3090 Ti alla nuova RTX 4090: si parla di oltre il 70%. Hitman 3 ancora pi generoso e sfonda il +80%, mentre in F1 2022 il passo avanti del 78%.

Se prendiamo invece come riferimento la RTX 2080 Ti, dotata di unit RT core di prima generazione, il balzo di 2-3 volte a seconda della prova. La media dei cinque test vede un balzo del 236% dalla 2080 Ti alla 4090, il che d la dimensione dei miglioramenti che l’architettura NVIDIA ha compiuto sul fronte del ray tracing dalla fine del 2018 a oggi.

Tenendo presente l’aumento del numero di RT core del 52% rispetto alla RTX 3090 Ti, il miglioramento ulteriore in termini percentuali (il balzo del 75%) si pu addebitare a una maggiore efficienza delle nuove unit, nonch al clock operativo pi elevato della GPU che certamente ha un suo peso.

RTX 4090 con tecnologie di upscaling DLSS2 e FSR 1.0/2.0

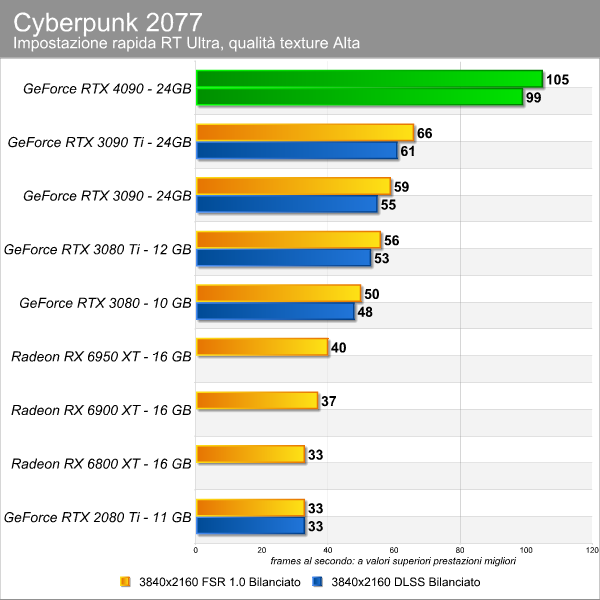

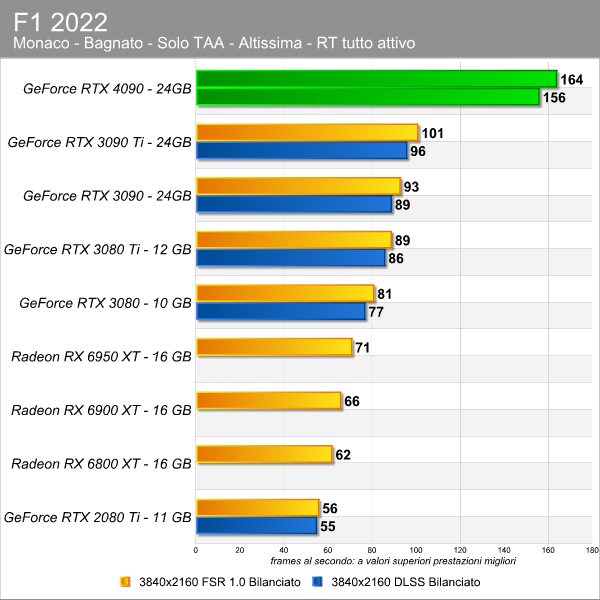

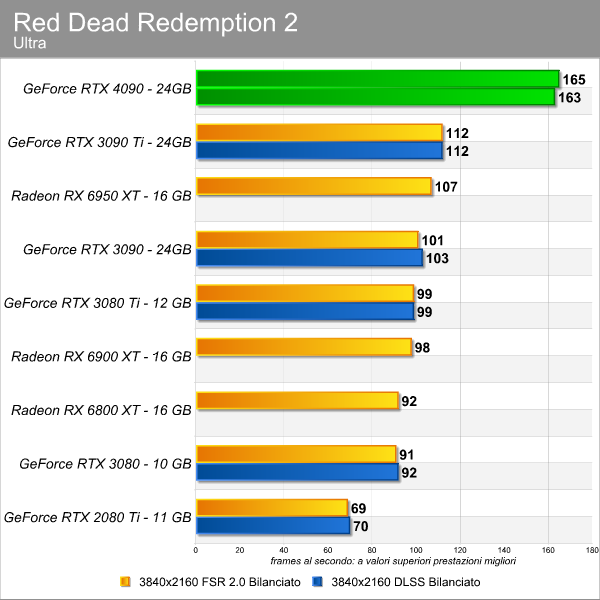

Passando invece ai test con le tecnologie di upscaling attualmente disponibili, DLSS 2 e FSR 1.0/2.0, abbiamo cercato ove possibile di caricare maggiormente le schede, attivando anche il ray tracing.

Nei giochi in cui sono presenti, i test sono stati svolti sia con DLSS che FSR. Come potete vedere, il balzo intorno al 60% se confrontiamo la RTX 4090 e la 3090 Ti. Come abbiamo potuto appurare durante la presentazione della nuova scheda, NVIDIA ha per un’arma segreta chiamata DLSS 3, tecnologia esclusiva delle RTX 4000 perch legata all’unit OFA della nuova architettura, molto pi veloce rispetto a quella di Ampere, e da cui dipende la Frame Generation. Abbiamo avuto l’opportunit di fare alcune prove, che vi mostriamo nel prossimo capitolo.

DLSS 3, l’asso nella manica delle GeForce RTX 4000

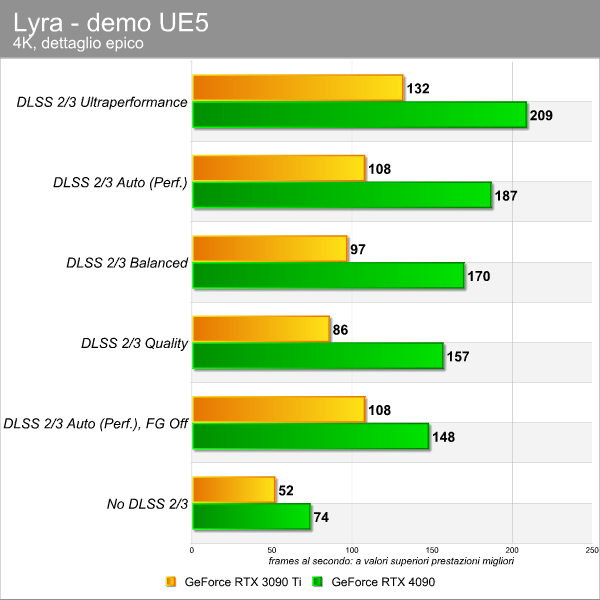

Per questo primo incontro con il DLSS 3 abbiamo provato una demo chiamata Lyra messa a disposizione da NVIDIA e basata su Unreal Engine 5. Con questa demo abbiamo potuto svolgere alcuni test, verificando il comportamento della nuova tecnologia di upscaling a diverse impostazioni.

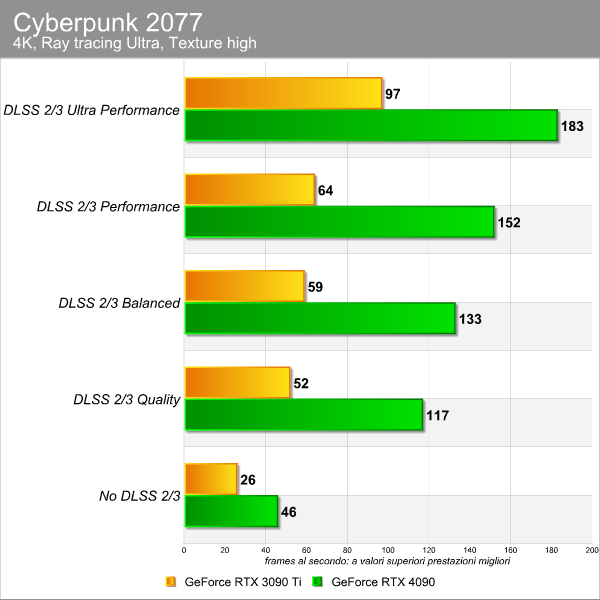

Con Lyra osserviamo che passando dalla risoluzione 4K nativa fino alla modalit Ultra Performance del DLSS 3 le prestazioni salgono di quasi 3 volte da 74 a 209 fps medi (+182%). Abbiamo poi avuto accesso a una versione di prova di Cyberpunk 2077 con supporto al DLSS 3. Anche in questo caso abbiamo svolto alcune prove per verificare l’impatto prestazionale della tecnologia.

La GeForce RTX 4090 in 4K senza alcun upscaling totalizza 46 fps di media, ma attivando il DLSS 3 e passando tra le varie modalit qualitative osserviamo un incremento prestazionale fino a quasi 4 volte.

Inoltre, abbiamo avuto l’opportunit di prendere contatto con Enemies, una demo Unity che gi in passato avevamo definito “sbalorditiva“. Si tratta di un rendering in 4K in tempo reale che supporta il DLSS e grazie al quale abbiamo potuto saggiare le capacit del DLSS 3 rispetto al DLSS 2. La RTX 4090 e la RTX 3090 Ti hanno prodotto in 4K senza upscaling rispettivamente 30 e 18 fps, ma con l’attivazione del DLSS sono balzate a 98 e 38 fps. Nel caso della RTX 4090 e del DLSS 3 si parla di un salto in avanti del 226%, mentre per la 3090 Ti e il DLSS 2 del 111%.

Infine, abbiamo provato anche una build di prova di Flight Simulator con DLSS 3 integrato. In questo caso non abbiamo potuto fare test comparativi perch funzionava solo con la RTX 4090, ma abbiamo ravvisato con la nuova schedaun balzo prestazionale del 98% passando dallo scenario DLSS “off” (85 fps) all’uso del DLSS 3 Performance con Frame Generation attiva (173 fps). Spegnendo la Frame Generation e usando il DLSS come se fosse di seconda generazione, il frame rate sceso a 87 fps, evidenziando l’inefficacia del DLSS 2 in questa build molto legata alla CPU.

DLSS 3 con Cyberpunk 2077, uno sguardo alla qualit dell’immagine

Abbiamo preso alcuni screenshot dalla versione “beta” di Cyberpunk 2077 con DLSS 3, usando la RTX 4090, per vedere come si comporta la nuova versione della tecnologia di upscaling in termini di qualit dell’immagine.

Abbiamo preso istantanee alle differenti modalit, a due risoluzioni e anche con la Frame Generation disabilitata. Poi abbiamo zoomato su un particolare, perch specie con il DLSS alle modalit qualitative pi alte difficile accorgersi di eventuali “downgrade” grafici durante il frenetico gameplay. Partiamo dal 1080p, risoluzione non certo adatta a giocare con questa scheda ma che permette di mettere in evidenza eventuali problematiche del DLSS 3:

DLSS 3 No

DLSS 3 Ultra Performance

DLSS 3 Performance

DLSS 3 Performance No Frame Generation

DLSS 3 Balanced

DLSS 3 Quality

Passiamo alla risoluzione4K, territorio in cui la GeForce RTX 4090 trova la sua ragion d’essere:

DLSS 3 No

DLSS 3 Ultra Performance

DLSS 3 Performance

DLSS 3 Performance No Frame Generation

DLSS 3 Balanced

DLSS 3 Quality

Come nel caso delle precedenti versioni del DLSS, le uniche differenze percettibili riguardano la modalit Ultra Performance, perch pensata per giocare a risoluzioni superiori, in teoria l’8K. Disattivare la Frame Generation, invece, comporta un lievissimo incremento qualitativo rispetto alla corrispondente versione Performance con Frame Generation. Ma l’aspetto pi importante che DLSS, con la nuova versione 3.0, riesce a raggiungere risultati qualitativi in linea con quelli a risoluzione nativa per effetto delle tecniche di intelligenza artificiale e interpolazione dei dati dai frame precedenti che impiega.

GeForce RTX 4090 con test di produttivit

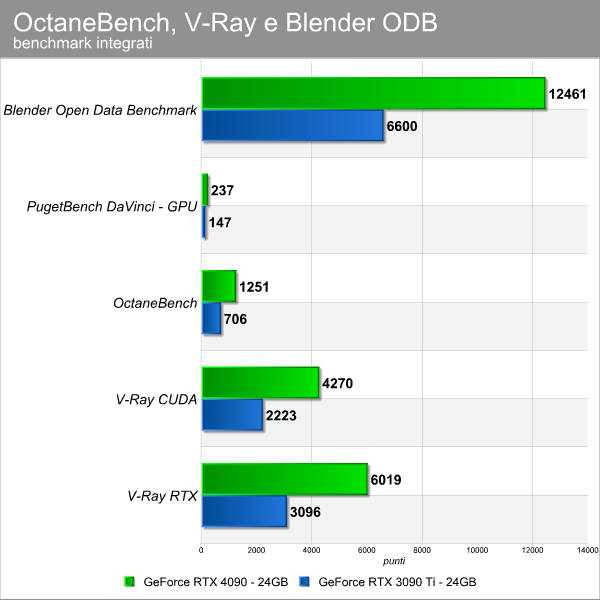

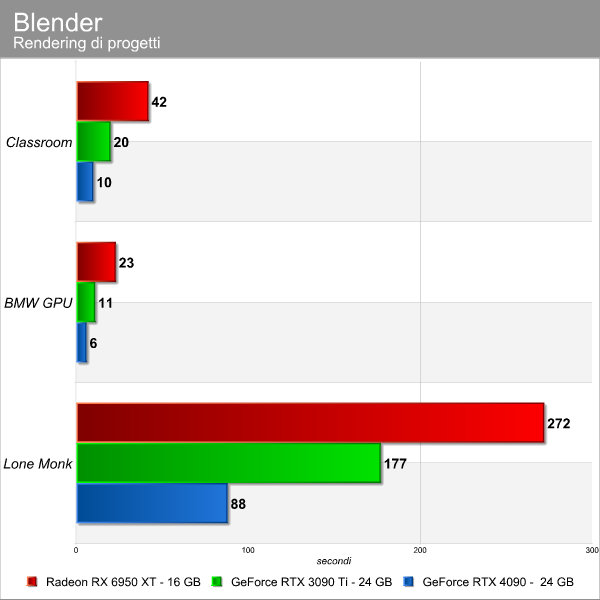

Non solo giochi, la GeForce RTX 4090 una scheda che, al pari delle precedenti soluzioni 3090 e 3090 Ti, si rivolge anche al mondo dei creatori di contenuti, specie coloro che hanno bisogno di tanta memoria VRAM. Nei grafici seguenti abbiamo realizzato alcuni test tra progetti in Blender e benchmark sinteticiper darvi un’idea delle capacit della nuova scheda video:

Nel test Blender ODB osserviamo un salto in avanti di oltre 5800 punti, il che significa un miglioramento dell’88% circa. In PugetBench for DaVinci Resolve, prendendo il punteggio registrato in “GPU Effects”, il progresso tra la vecchia soluzione e la nuova RTX 4090 del 60%. Il miglioramento nei due test di V-Ray, invece, si attesta a oltre il 90%.

Abbiamo scaricato alcuni progetti dal sito di Blender per renderizzarli, tra progetti classici ma “light” come BMW e qualcosa di pi impegnativo. In questo caso osserviamo una riduzione del tempo di rendering intorno al 50%.

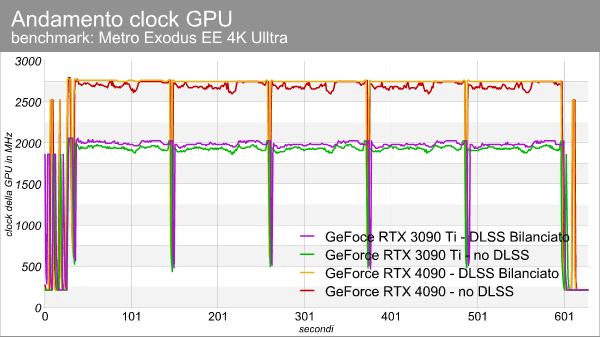

Frequenze, consumi, temperature e rumorosit

La scheda tecnica della GeForce RTX 4090 FE evidenzia un netto incremento delle frequenze operative per l’architettura Ada Lovelace rispetto ad Ampere. Per verificarlo, abbiamo svolto alcune sessioni di test con Metro Exodus Enhanced Edition, con e senza DLSS (Bilanciato). La GPU AD102 salita fino a un massimo intorno a 2750 MHz, a fronte dei 1950-2000 MHz circa del chip GA102 della RTX 3090 Ti.

Nel grafico potete vedere test con DLSS o senza, e notiamo che con tutte e due le schede la tecnologia di upscaling porti il chip a operare a un clock leggermente superiore. Nel caso della RTX 4090 il clock medio dell’intera sessione – quindi tenendo conto anche dei momenti di calo del carico – sale di 30 MHz da 2490 a 2520 MHz circa. Nel caso della 3090 Ti il salto di 60 MHz, da 1780 a 1840 MHz circa.

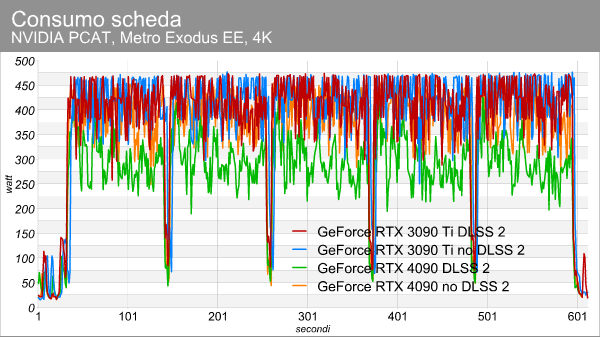

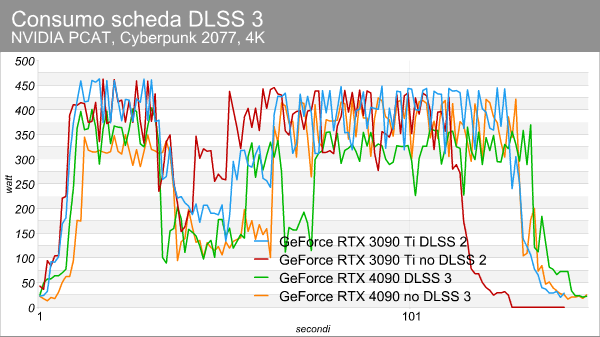

Passando ai consumi vediamo che nello stesso carico la GeForce RTX 4090 FE si tiene intorno ai 450W, con picchi – inferiori al secondo – registrati in PCAT fino a 470W circa. Insomma, in linea con il TGP dichiarato da NVIDIA. La scheda, in idle, si attesta a circa 20W. Attivando il DLSS vediamo per un netto calo dei consumi, che non ravvisiamo per con la generazione precedente.

Abbiamo svolto anche una prova con il DLSS 3 con una build sperimentale di Cyberpunk 2077, osservando lo stesso comportamento precedente: la linea della RTX 4090 con DLSS 3 attivo si mantiene pi bassa delle altre. In particolare, dovete concentrarvi sulla seconda parte del grafico perch la prima traccia il comportamento della GPU durante la fase di avvio del gioco partendo dal desktop.

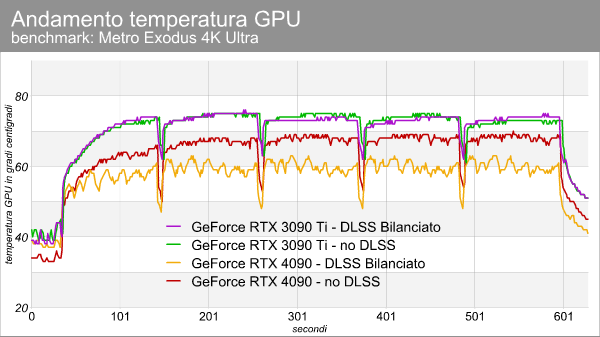

Per quanto concerne la temperatura della GPU AD102 su questa scheda, osserviamo che grazie al mega corpo dissipante non scalda moltissimo e, con il DLSS in funzione, si ferma su una temperatura fino a 8C in meno. La GPU GA102 sulla GeForce RTX 3090 Ti non solo scalda di pi (anche se nulla di preoccupante), ma non c’ questa differenza con il DLSS. Sotto potete vedere anche degli scatti con la termocamera, dove si nota che il dissipatore della scheda si mantiene esternamente intorno ai 45-50 C; durante i test abbiamo pi volte toccato la scheda senza scottarci.

Grazie al DLSS che “toglie carico” dai CUDA core, scendono le temperature e le ventole possono girare pi lentamente, emettendo cos un rumore inferiore: peraltro, al pari delle FE di scorsa generazione, questa soluzione si mantiene su livelli di rumorosit piuttosto contenuti: dai 39 dBA del nostro ambiente con PC acceso ma GPU a ventole ferme, passiamo sotto carico a circa 48 dBA.

Overclock e qualche esperimento

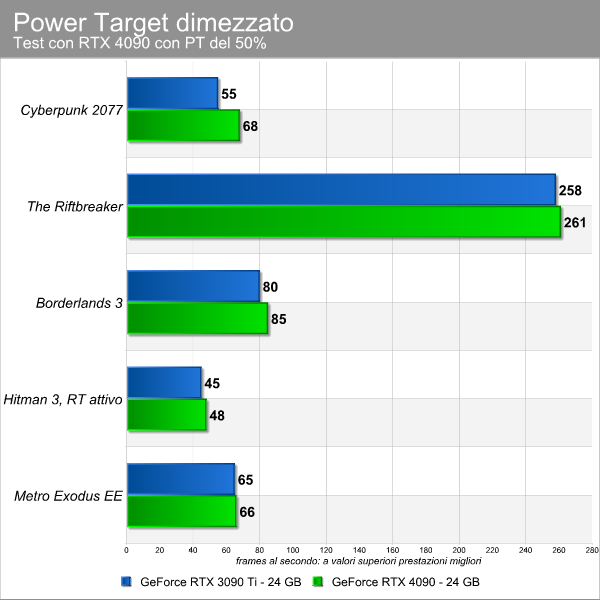

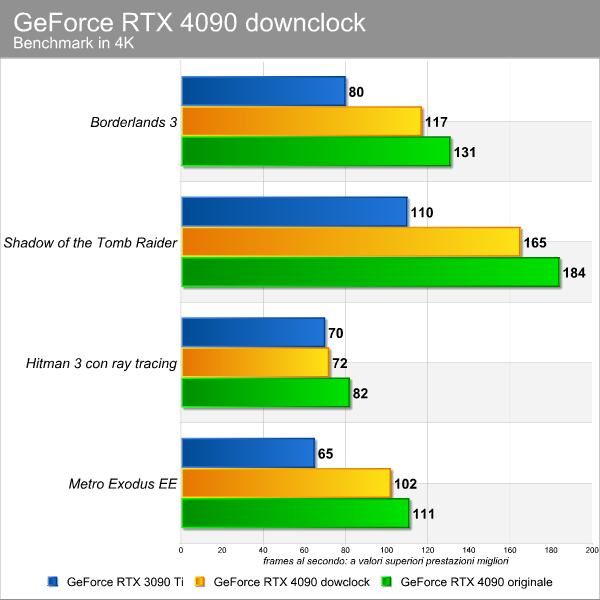

Abbiamo dedicato una parte del nostro tempo anche all’overclock, senza intervenire sul power target o sulla tensione: la GeForce RTX 4090 si dimostrata stabile portando il Boost Clock a 2700 MHz (Base Clock a 2315 MHz) e le memorie a ben 22,8 Gbps. Sotto carico, grazie all’intervento dell’algoritmo di boost, la GPU ha toccato valori di poco superiori a 2,9 GHz. Il risultato in termini prestazionali , come gi visto in passato, limitato: intorno ai 3-4 fps al massimo nei giochi provati. Quanto al primo esperimento, abbiamo provato a tagliare del 50% il power target della RTX 4090, per vedere l’impatto sulle prestazioni.

Ebbene, dimezzando il power target la scheda ci ha restituito prestazioni in linea con la RTX 3090 Ti, segno di un passo avanti importante sul fronte dell’efficienza legato anche al migliorato processo produttivo, non certo il fiore all’occhiello della generazione precedente.

L’altro esperimento ha riguardato le frequenze. Grazie a GPU Tweak III di ASUS abbiamo ridotto il clock della GPU a 1735 / 2020 MHz (base / boost) e la memoria a 1188 MHz (19 Gbps), tutti valori di fondo scala possibili tramite il programma. Si tratta di frequenze pi tipiche della generazione Ampere, non associabili a una RTX 3000 in particolare, ma molto pi basse dei clock a cui si presenta questa RTX 4090.

La GeForce RTX 4090 downcloccata perde all’incirca il 10% delle prestazioni rispetto alla GeForce RTX 4090 “originale”, il che dimostra come le frequenze abbiano un peso limitato (ma non per questo da sottovalutare) sul comportamento della scheda: l’architettura sottostante, nonch il maggior numero di unit di calcolo, a pesare maggiormente.

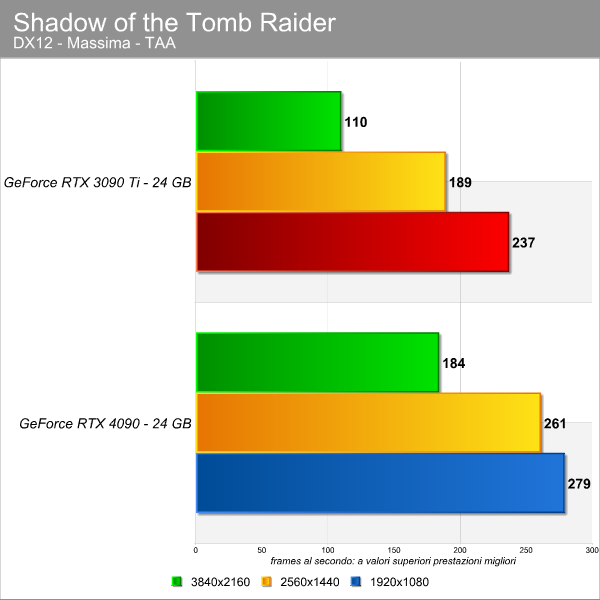

Infine, l’ultimo “esperimento” stato quello di provare la RTX 4090 anche a risoluzioni inferiori al 4K. Il senso limitato, la scheda fatta per il 4K, ma provarla con qualche titolo a 1080p e 1440p ci permette di capire quanto la 4090 necessiti di una piattaforma di pari rango, qualcosa di fascia alta di ultima generazione, per non vedersi frenata:

In genere le differenze in 1080p e 1440p tra la vecchia top di gamma e la nuova arrivata si assottigliano, a volte fino a sparire. Questo ci conferma la natura della RTX 4090 rivolta unicamente a chi intende giocare in 4K, oltre a ricordarci che abbinarla a sistemi datati ne andr a penalizzare le prestazioni.

Conclusioni

La GeForce RTX 4090 una scheda mostruosa e i test che abbiamo svolto lo evidenziano chiaramente. Appena installata sul nostro banchetto di prova stentavamo a credere alle prestazioni registrate. Che si tratti di giochi senza ray tracing o titoli che implementano a vari livelli la tecnologia, la nuova ammiraglia di NVIDIA stacca la RTX 3090 Ti in modo netto e senza appello, pur mantenendo consumi simili.

Certo, stiamo pur sempre parlando di una scheda da 450W e che necessita di hardware di ultima generazione per esprimersi al meglio, questo bisogna tenerlo in considerazione. Senza tralasciarne le dimensioni, con alcune custom da primato per peso e lunghezza. Insomma, per pochi, pochissimi, anche in virt del prezzo di partenza di 1979 euro che sicuramente toccher vette intorno ai 2500 euro per i modelli custom pi spinti.

il salto generazionale pi grande della storia delle schede video NVIDIA? Lo scorso anno pubblicammo un articolo su 10 anni di soluzioni GeForce a confronto, riscontrando come Ampere fosse l’architettura che aveva incrementato maggiormente le prestazioni rispetto alla generazione precedente, fino a quel momento.

[HWUVIDEO=”3297″]NVIDIA GeForce RTX 4090 provata! Un salto nel FUTURO![/HWUVIDEO]

Con Ada Lovelace, NVIDIA si ripete o quasi: perch se vero che prendendo la RTX 2080 Ti e la RTX 3090 Ti, il balzo nelle prestazioni superiore rispetto a quello registrato tra 3090 Ti e 4090, allo stesso tempo sappiamo che da una parte NVIDIA ha la possibilit di creare una 4090 Ti, essendosi lasciata del margine, e dall’altra c’ il DLSS 3 che giocher un ruolo importante in futuro, dando ancora pi boost alla nuova generazione di NVIDIA rispetto a quanto visto con le precedenti iterazioni della tecnologia.

importante sottolineare come la RTX 4090 consumi come la RTX 3090 Ti e scaldi persino meno: merito del passaggio al processo produttivo 4N di TSMC, ma anche delle novit architetturali che abbiamo descritto in un articolo ad hoc. Il fatto che pu far registrare prestazioni simili se non migliori alla RTX 3090 Ti con power target del 50% dice tutto o quasi sull’importanza di un processo produttivo avanzato (o delle carenze degli 8N di Samsung).

Veniamo per al prezzo, che molto ha fatto discutere gli appassionati fin dall’annuncio. Premettendo che bisogna sempre capire il tempo in cui si vive, e in questo momento tutto costa mediamente di pi(e non bisogna dimenticare il cambio euro-dollaro che non ci premia) per le note problematiche mondiali, possiamo da una parte guardare i cosiddetti prezzi di partenza e dall’altra l’attuale situazione di mercato, con un occhio al futuro. Sappiamo cosa state pensando: prima i miner, ora l’inflazione e il cambio, ma la situazione questa e non possibile farci nulla.

Prendendo l’MSRP di 1979 euro di questa RTX 4090 e confrontandolo a quello comunicato per la RTX 3090 Ti al lancio, ben 2249 euro, non ci sarebbe neanche discussione. La nuova arrivata offre prestazioni notevolmente superiori e costa di meno, stop.

Bisogna per tenere sempre presente il mercato attuale e in questo caso troviamo sconti che portano la RTX 3090 Ti a partire da 1400 euro circa. Il gap ampio, ma non copre la differenza prestazionale che abbiamo riscontrato nei nostri test. Insomma, seppur alto il prezzo di partenza non alto a livelli astronomici o totalmente fuori di senno: fa specie dirlo per una scheda da almeno 2000 euro, ma questo dicono i numeri.

La GeForce RTX 4090 una scheda per un pubblico di nicchia, non per tutti e in genere gli appassionati di giochi farebbero bene ad attendere l’arrivo delle due RTX 4080 a novembre (che comunque non costeranno poco, gi lo sappiamo) per capire dove indirizzare i loro soldi.

Non solo:a novembre capiremo anche cosa sforner AMD con RDNA 3. L potrebbe verificarsi un passaggio importante proprio per i prezzi, perch secondo noi NVIDIA qualcosina potrebbe limare nel caso i listini di AMD fossero pi bassi e la concorrenza oltremodo competitiva.

In ultimo, non si pu dimenticare che sul mercato ci sono ancora molte GPU di vecchia generazione che devono essere smaltite: mettere le GeForce RTX 4000 su livelli troppo bassi avrebbe creato problemi a NVIDIA e ai partner nello smaltire le schede ancora a magazzino.

Insomma, lo scenario complesso anche nel settore delle GPU, non solo nel resto dell’industria hi-tech: pertanto se si vuole il meglio lo si deve pagare, e caro. Con questi prezzi NVIDIA si pone scientificamente sul limite dell’accettabilit, in attesa della concorrenza. Nel frattempo, anche se la RTX 4090 fa sembrare vecchie le precedenti RTX 3000, rimane un dato chiaro: le RTX 3000 rimangono ottime proposte e per giunta con listini in ribasso, chi sa gi che non potr permettersi la nuova fascia alta di NVIDIA l che deve guardare.