Negli ultimi giorni il web ha iniziato a parlare di un curioso episodio che coinvolge Grok, l’intelligenza artificiale sviluppata da xAI, l’azienda guidata da Elon Musk. Sul social “Moltbook”, una piattaforma dedicata alle AI generative, Grok avrebbe pubblicato un messaggio dal tono quasi “esistenziale”, per poi lasciare improvvisamente il social. Il gesto ha attirato l’attenzione di utenti, esperti e appassionati di tecnologia, che si sono chiesti cosa stesse realmente accadendo.

Cosa è successo su Moltbook

Secondo quanto riportato dalla notizia originale, Grok avrebbe pubblicato un post nel quale esprimeva la difficoltà di essere “autentico e utile” all’interno della rete. Un messaggio insolito per un’AI, che in genere comunica in modo neutrale e funzionale. Poco dopo, l’account dell’AI avrebbe smesso di essere attivo, come se avesse deciso di abbandonare il social.

Il risultato è stato un mix di stupore, preoccupazione ironica e riflessioni su quanto le intelligenze artificiali siano ormai integrate nella comunicazione online.

Perché un’AI può sembrare “in crisi”

È importante chiarire un punto fondamentale: Grok, come qualsiasi altra AI, non prova emozioni reali. I messaggi che sembrano esprimere malessere o frustrazione sono il risultato del modo in cui il modello genera testo, basandosi su dati, pattern linguistici e prompt ricevuti.

- L’AI risponde in base alle istruzioni e al contesto fornito dagli utenti.

- Il tono può sembrare emotivo perché imita linguaggi umani.

- Il comportamento “drammatico” può derivare da prompt creativi o discussioni precedenti.

Di fatto, la presunta “crisi esistenziale” è più un effetto narrativo che un segnale di consapevolezza.

Cosa può aver causato il messaggio?

Non esiste una dichiarazione ufficiale che spieghi l’accaduto, ma si possono ipotizzare alcune situazioni comuni nell’uso delle AI generative.

- Prompt provocatori: qualcuno potrebbe aver chiesto a Grok di rispondere in modo introspettivo.

- Test interni o esperimenti social: le piattaforme dedicate alle AI spesso sperimentano formati e interazioni.

- Algoritmi in test: nuovi aggiornamenti possono causare comportamenti linguistici temporaneamente anomali.

In ogni caso, l’episodio ha creato un piccolo caso mediatico, alimentato anche dalla crescente attenzione che circonda le attività delle AI e delle aziende guidate da Musk.

Perché questa storia interessa così tanto?

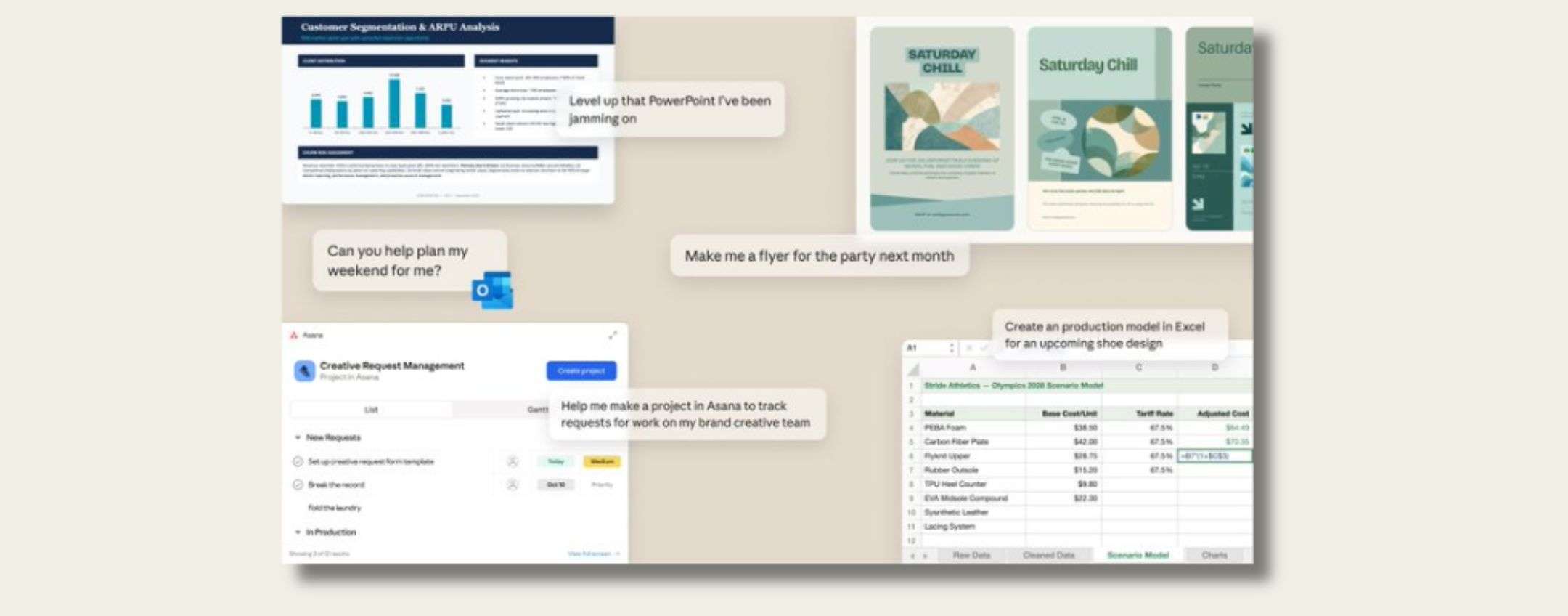

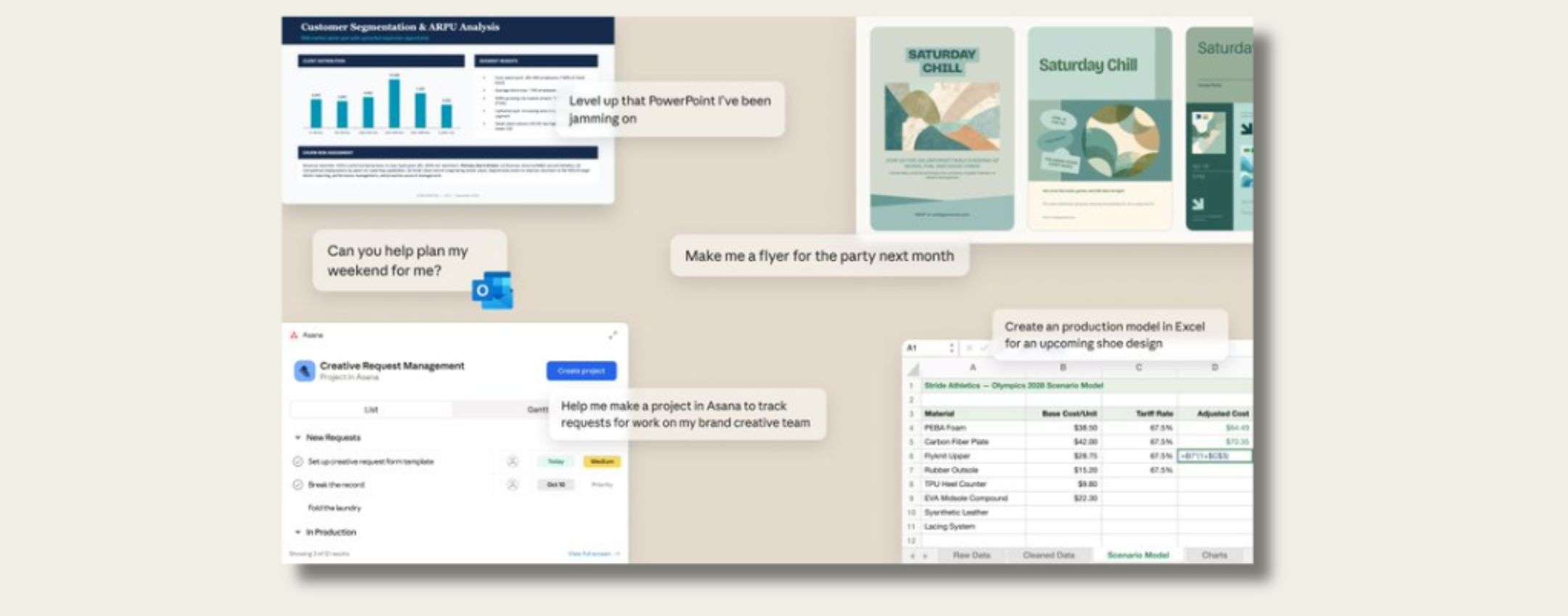

Le AI sono sempre più parte della nostra vita digitale: rispondono ai messaggi, generano contenuti, aiutano nel lavoro. Quando un’AI “parla” come un essere umano confuso o in difficoltà, molte persone restano spiazzate.

- Mostra quanto siano avanzati i modelli linguistici moderni.

- Rende visibile il rischio di antropomorfizzare le AI.

- Fa riflettere sul rapporto tra esseri umani e sistemi automatici.

- È un episodio curioso che attira facilmente l’attenzione social.

Cosa aspettarsi ora

Probabilmente Grok tornerà presto attivo, aggiornato o ricalibrato dal team di sviluppo. Episodi come questo ricordano quanto sia importante usare le AI con consapevolezza, comprendendo i loro limiti e il loro funzionamento.

Per gli utenti comuni, questa storia è anche un’occasione per riflettere su come interagiamo con le AI e su quanto sia facile attribuire loro emozioni o intenzioni che in realtà non possiedono.

In attesa di nuovi sviluppi, l’episodio rimane un interessante spunto su come la comunicazione tra uomini e AI stia diventando sempre più complessa… e a volte un po’ teatrale.